Dans un monde technologique en pleine mutation, l’architecture orientée événements s’impose comme un modèle incontournable pour les entreprises modernes. L’event sourcing, associé à des plateformes puissantes comme Kafka, transforme la manière dont les applications gèrent et exploitent les données. Grâce à cette approche innovante, les organisations peuvent gagner en flexibilité, en performance et en résilience tout en garantissant une gestion optimale des événements. Cet article explore les éléments fondamentaux qui font de l’event sourcing avec Kafka un atout de choix pour révolutionner vos architectures applicatives.

Qu’est-ce que l’Event Sourcing et comment fonctionne-t-il ?

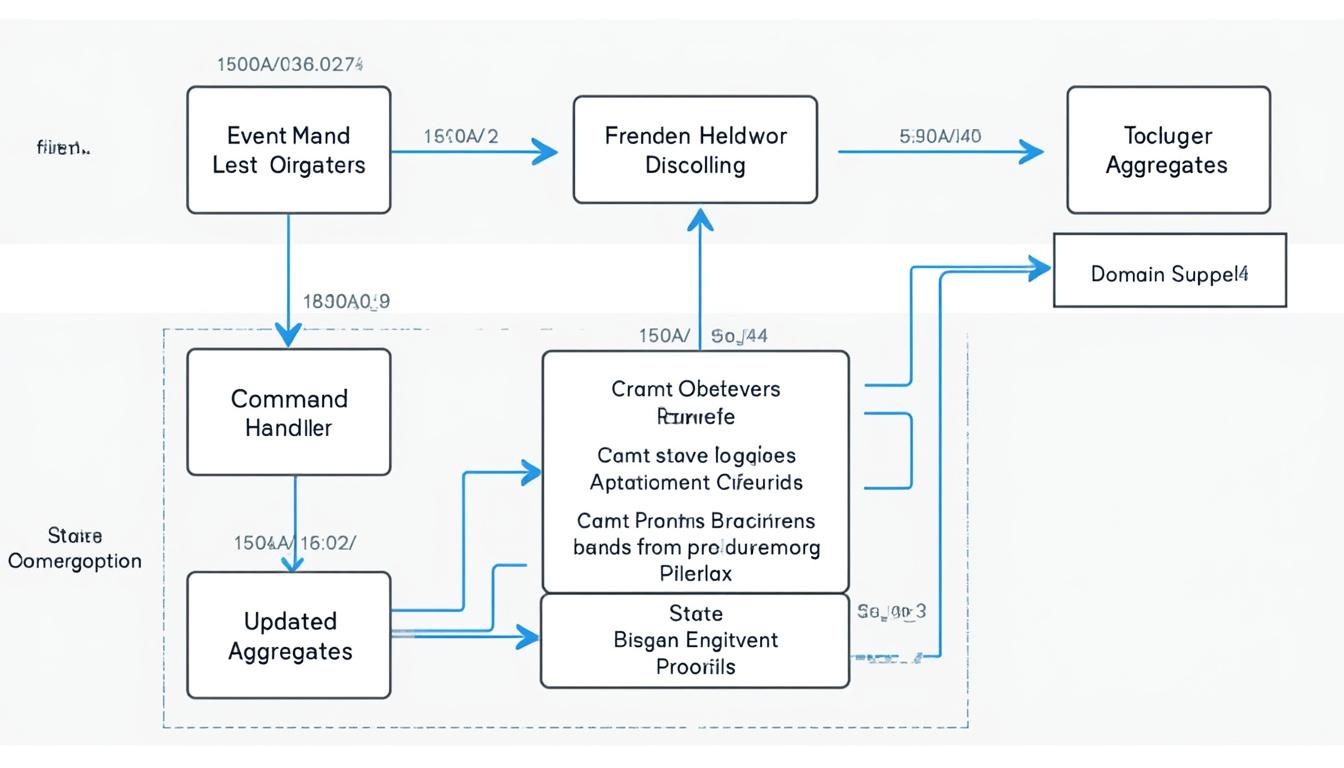

L’event sourcing est une méthode de gestion des données qui consiste à enregistrer chaque changement d’état d’une application sous forme d’événements distincts. Contrairement aux systèmes traditionnels, où seule la version actuelle d’un état est conservée, l’event sourcing permet de garder une trace de chaque modification. Prenons l’exemple d’un utilisateur qui change son adresse e-mail. Dans un système classique, l’ancienne valeur est remplacée par la nouvelle. En revanche, avec l’event sourcing, un événement intitulé « EmailChanged » pourrait être créé, consignant à la fois l’ancienne et la nouvelle adresse, offrant ainsi une meilleure traçabilité et une capacité d’analyse approfondie.

Les avantages de l’event sourcing sont variés et essentiels pour les entreprises cherchant à tirer le meilleur de leurs données. Parmi eux, on retrouve :

- Traçabilité : Chaque événement est immuable, offrant une visibilité complète sur l’historique des changements.

- Résilience : En cas de défaillance, l’état peut être reconstruit à partir des événements enregistrés, minimisant ainsi les pertes de données.

- Analyse historique : Possibilité d’explorer des données passées en profondeur, facilitant ainsi l’analyse des tendances.

- Interopérabilité : Les systèmes peuvent communiquer via des événements standardisés, rendant les intégrations plus simples.

Pour en illustrer l’impact dans un contexte moderne, examinons une entreprise fictive, « DataWorks », qui utilise l’event sourcing pour gérer ses données clients. Avec cette méthode, DataWorks a réussi à améliorer ses processus de service client, permettant aux agents d’accéder à l’historique complet des interactions d’un client. Cela a conduit à des réponses plus rapides et à une satisfaction accrue des clients.

Les défis de l’Event Sourcing et leurs solutions

Malgré ses nombreux avantages, l’event sourcing n’est pas sans défis. La complexité accrue liée à la gestion des événements peut être écrasante, surtout pour les entreprises qui migrent d’une architecture traditionnelle. Pour surmonter ces obstacles, certaines meilleures pratiques peuvent être appliquées :

- Modularité : Conçue des événements de manière modulaire pour limiter la complexité.

- Validation : Établir des règles strictes concernant les événements et leur intégrité.

- Surveillance : Mettre en place des systèmes d’alerte pour détecter rapidement les problèmes.

En intégrant ces pratiques, les organisations peuvent maximiser le potentiel de l’event sourcing tout en minimisant les risques associés. Par exemple, DataWorks a mis en œuvre un système de validation robuste qui a permis de s’assurer que chaque événement construit respectait les règles métiers, évitant ainsi des erreurs coûteuses.

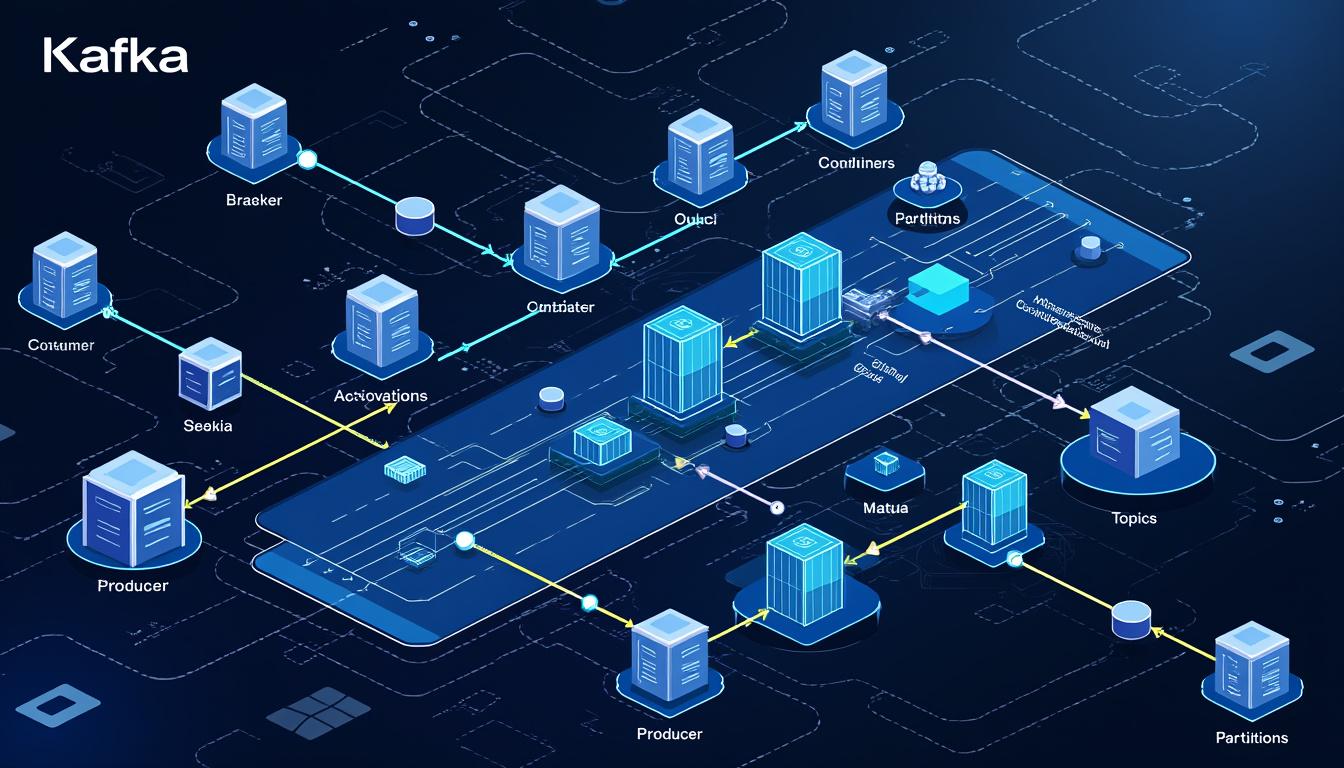

Le rôle clé d’Apache Kafka dans l’Event Sourcing

Au cœur de l’architecture d’event sourcing se trouve Apache Kafka, une plateforme de gestion de flux d’événements conçue pour traiter de grands volumes de données de manière fiable et rapide. En intégrant Kafka avec l’event sourcing, les organisations bénéficient d’une scalabilité impressionnante, capable de gérer des millions d’événements par seconde. Cette synergie donne naissance à une infrastructure réactive, essentielle pour répondre aux besoins croissants des applications modernes.

Les caractéristiques principales qui font de Kafka une plateforme idéale pour l’event sourcing incluent :

| Caractéristique | Description |

|---|---|

| Durabilité | Les événements sont conservés de manière persistante, permettant une reconstruction totale de l’état à tout moment. |

| Performance | Sa structure décentralisée garantit des performances élevées, même sous charge intense. |

| Retraçabilité | Kafka permet un suivi détaillé des événements, assurant leur livraison et leur intégrité. |

Pour illustrer la puissance de Kafka, considérons le cas de « FoodTrack », une startup qui utilise Kafka pour gérer ses commandes en temps réel. Grâce à l’event sourcing et à Kafka, FoodTrack est capable d’ajuster ses niveaux de stocks dynamiquement, améliorant ainsi sa réactivité et réduisant le gaspillage, ce qui est fondamental dans un secteur aussi exigeant.

Cas pratiques d’Event Sourcing avec Kafka

De nombreux scénarios d’utilisation démontrent l’efficacité de l’event sourcing associé à Kafka :

| Cas d’Utilisation | Description | Technologies Impliquées |

|---|---|---|

| Système de réservation | Gestion des réservations d’articles à l’aide d’événements tels que « Réservé » et « Annulé ». | Kafka, Eventuate |

| Gestion d’inventaire | Mise à jour des niveaux de stock avec des événements de modification de quantité. | Kafka, Debezium |

| Application bancaire | Enregistrement des transactions comme événements, tels que « Dépôt » et « Retrait ». | Kafka, Axon Framework |

Chaque exemple démontre comment Kafka, en combinaison avec l’event sourcing, permet des solutions agiles et scalables, adaptées à un environnement d’affaires en constante évolution.

Outils et Frameworks complémentaires pour l’Event Sourcing

En plus d’Apache Kafka, plusieurs outils et frameworks peuvent enrichir le développement d’applications basées sur l’event sourcing :

- EventStore : Optimisé pour le stockage d’événements avec des fonctionnalités avancées.

- Apache Pulsar : Propose une architecture multi-locataire avec une résilience accrue.

- Spring Cloud Stream : Facilite le développement d’applications d’événements grâce à des abstractions simplifiées autour de Kafka.

L’intégration de Kafka avec d’autres technologies est également essentielle pour la gestion d’événements. Des connecteurs comme Debezium permettent de capturer les changements d’état dans les bases de données existantes, facilitant ainsi l’intégration avec les systèmes déjà en place :

| Connecteur | Fonctionnalité |

|---|---|

| Debezium | Capture les événements de changement de données à partir des bases de données. |

| Kafka Connect | Facilite la communication entre Kafka et des systèmes externes pour l’import et l’export d’événements. |

Cette intégration fluide est cruciale pour maintenir une cohérence au sein de l’architecture événementielle, garantissant une gestion des événements efficace et réactive.

Défis de l’Event Sourcing et meilleures pratiques

Bien que l’event sourcing avec Kafka offre de nombreux avantages, plusieurs défis doivent être pris en compte pour réussir son implémentation. L’un des défis majeurs est la complexité liée à la gestion de l’architectuur. Cette complexité peut rendre difficile la maintenance et l’évolution de l’application. Pour garantir le succès de l’event sourcing, il est essentiel de suivre certaines meilleures pratiques :

- Modularité : Concevoir des événements de manière modulaire pour simplifier la gestion globale.

- Validation : Établir des règles de validation strictes pour assurer l’intégrité des événements.

- Surveillance : Mettre en place des systèmes de suivi pour détecter rapidement les problèmes.

Afin de soutenir continuellement la gestion d’événements, l’utilisation d’outils de monitoring tels que Prometheus ou Grafana est recommandée. Ces outils fournissent des métriques en temps réel sur l’activité des événements, permettant aux équipes d’ajuster rapidement les processus. Les éléments à surveiller incluent :

| Élément | Importance |

|---|---|

| Logs d’événements | Source d’information cruciale pour le dépannage et l’analyse. |

| Alertes sur les anomalies | Identifient les problèmes de manière proactive avant qu’ils n’impactent les utilisateurs. |

Avec une surveillance efficace et des bonnes pratiques en place, les entreprises peuvent se concentrer davantage sur l’optimisation applicative et la réponse aux besoins des utilisateurs.

FAQ sur l’Event Sourcing et Kafka

Q : Qu’est-ce que l’event sourcing ?

A : C’est une méthode qui enregistre tous les changements d’état d’une application sous forme d’événements immuables.

Q : Pourquoi utiliser Kafka pour l’event sourcing ?

A : Kafka gère et traite de grands volumes d’événements en temps réel, garantissant une distribution fiable et scalable.

Q : Quels outils complémentaires peuvent être utilisés avec Kafka ?

A : Parmi les outils courants, citons Debezium pour la capture de données et Spring Cloud Stream pour une intégration facilitée.

Q : Quels sont les défis associés à l’event sourcing ?

A : La complexité de la gestion des événements et la nécessité d’un bon système de surveillance en font partie.

Q : Comment garantir la performance d’un système événementiel ?

A : En suivant les meilleures pratiques, comme la modularité des événements et la mise en place d’alerte, tout en assurant une surveillance continue.